Mengenal Data Crawling: Pengertian, Manfaat, dan Cara Kerjanya

Cahaya Muslim

20 June 2024 07:32

Data crawling menjadi suatu hal yang penting bagi bisnis Anda. Pasalnya, saat ini data yang berasal dari internet atau web sangatlah dibutuhkan untuk pengambilan keputusan yang lebih baik.

Data crawling berkaitan dengan bagaimana sebuah data dijelajahi sehingga bisa diambil untuk dijadikan insight berharga. Seperti diketahui, data yang tersebar di internet sangatlah banyak. Oleh sebab itu, dibutuhkan crawling yang baik dan tepat agar bisa dianalisis sesuai kebutuhan bisnis.

Seperti apa penjelasan lengkapnya? Simak semua di sini!

Baca Juga: Perbedaan Data Crawling dan Scraping Data

Apa itu Data Crawling?

Data crawling adalah proses pengumpulan data atau informasi dari berbagai website yang dilakukan secara otomatis. Istilah ini juga bisa disebut proses perayapan yang mengindeks data dari berbagai sumber online. Gambarannya, data crawling juga bisa diartikan sebagai kegiatan penjelajahan internet yang dilakukan oleh crawler atau bot untuk mengumpulkan data dari berbagai halaman website.

Proses ini dilakukan dengan cara pengunduhan halaman web dan ekstraksi informasi yang relevan dari halaman tersebut. Data-data yang biasa diambil umumnya berupa gambar, teks, angka, dan lain sebagainya.

Kegiatan crawling ini bisa dilakukan dengan berbagai tujuan, misalnya data crawling digunakan membangun indeks situs web sehingga pengguna mudah menemukan informasi yang mereka cari.

Selain itu, bisa juga digunakan untuk mengetahui berita terkini yang berkaitan dengan bisnis, tren pasar, bahkan memantau sentimen pelanggan. Data crawling juga dapat digunakan untuk menjadi bahan penelitian sehingga hasil penelitian lebih dipercaya.

Walaupun crawler bisa menjelajahi internet untuk mengambil data, Anda juga perlu mengingat bahwa ada aturan yang harus ditaati. Pemilik website bisa memasukkan kode tertentu untuk mencegah bot melakukan crawling terhadap halaman-halaman yang sensitif atau berisi informasi rahasia..

Manfaat Data Crawling

Data crawling bermanfaat untuk membantu mengumpulkan data-data yang dibutuhkan dari setiap halaman website. Dari data-data tersebut, analisis bisa dilakukan untuk mengubahnya menjadi insight berharga. Setidaknya, terdapat beberapa kegunaan dari data crawling. Di antaranya adalah sebagai berikut:

Analisis Big Data Lebih Tajam

Dengan data yang berhasil dicrawling, Anda bisa melakukan analisis big data secara lebih tajam. Data crawling dapat digunakan untuk memberikan wawasan yang berharga dalam pengambilan keputusan lebih baik.

Memantau Kompetitor

Data crawling memungkinkan Anda untuk mengetahui seperti apa kompetitor Anda. Dengan data crawling, Anda bisa memantau harga, penawaran, hingga strategi pemasaran dari kompetitor.

Melakukan Riset Pasar

Data crawling bisa membantu Anda dalam mengumpulkan data mengenai pasar. Anda bisa mengetahui informasi pasar, tren industri, preferensi konsumen, dan seperti apa perkembangan pasar terbaru.

Otomatisasi Pengumpulan Data

Pengumpulan data merupakan suatu hal yang kompleks untuk dilakukan. Oleh sebab itu, data crawling membantu dalam otomatisasi pengumpulan data. Jadi, data dapat dikumpulkan secara cepat dalam waktu yang lebih cepat dan mudah.

Cara Kerja Data Crawling

Data crawling bekerja dengan beberapa tahapan. Mulai dari mengunduh konten, mengekstraksi, hingga menyimpan. Berikut penjelasan lengkapnya untuk Anda.

Pembuatan Crawler

Tahapan pertama adalah pembuatan atau inisiasi crawler. Dalam tahapan ini, Anda harus menentukan tujuan crawling, merancang arsitekturnya, hingga menulis kode. Nantinya, crawler akan merayapi tautan antar halaman web untuk mengumpulkan data dari website telah ditentukan. Crawler diatur untuk merayapi URL apa yang akan dijelajahi.

Mengunduh Halaman Web

Setelah ditentukan URL atau situs yang ingin dijelajahi, crawler akan melakukan pengunduhan konten dari halaman web tersebut. Di sini, crawler mengakses halaman web melalui URL serta mengunduh kode-kode penting, seperti HTML, CSS, dan JavaScript yang membentuk halaman tersebut. Dari sini, crawler akan mendapatkan representasi lengkap dari halaman web, termasuk teks, gambar, dan elemen lainnya.

Mengekstraksi Data

Setelah itu, crawler akan melakukan ekstraksi data terhadap informasi yang relevan. Crawler akan mengidentifikasi dan melakukan ekstrak data yang diinginkan dari halaman web. Ekstraksi data bisa berupa teks, gambar, dan konten-konten lainnya.

Menyimpan Data

Terakhir, setelah crawler melakukan pengunduhan dan ekstraksi data, crawler akan melakukan penyimpanan data. Data disimpan dalam database sehingga bisa dianalisis lebih lanjut nantinya. Dari sinilah data-data yang telah dikumpulkan bisa dijadikan insight berharga berdasarkan data yang telah didapatkan dari hasil crawling.

Itulah penjelasan mengenai data crawling mulai dari artinya, manfaat, hingga bagaimana crawler atau bot bekerja untuk melakukan pengumpulan data. Walaupun menawarkan kemudahan dalam mengumpulkan data, tetapi data crawling juga memiliki tantangannya tersendiri.

Apa saja tantangan yang ada dalam data crawling? Klik di sini untuk mengetahui lebih lanjut: Tantangan Data Crawling

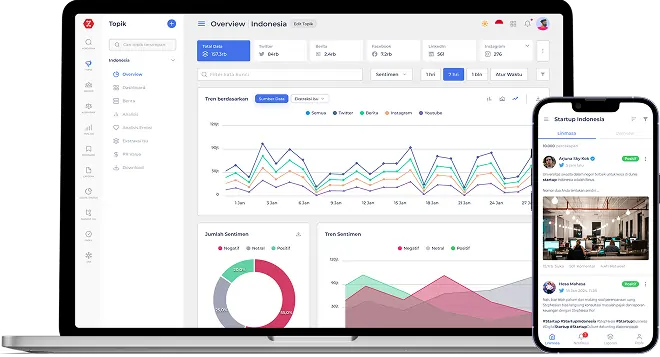

Media Intelligence

Media Intelligence

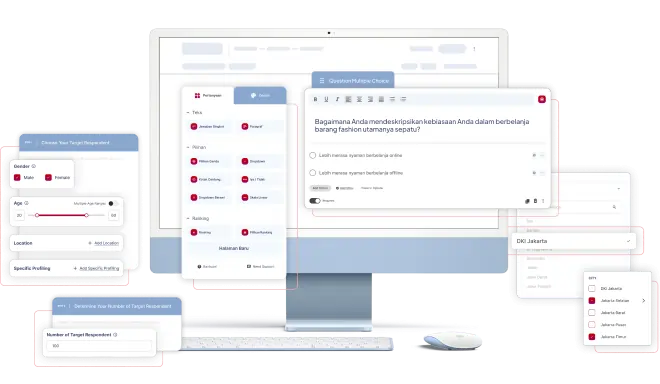

Research Intelligence

Research Intelligence

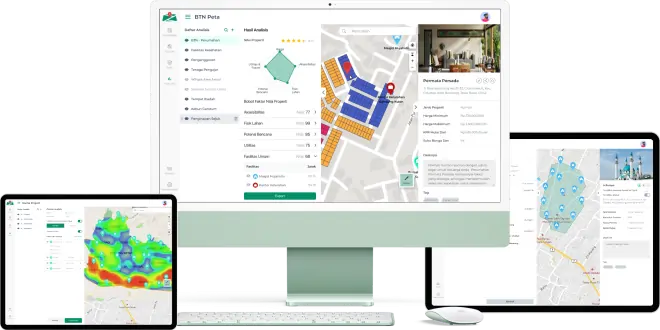

Location Intelligence

Location Intelligence

News Analysis

News Analysis  Solution By Departement

Solution By Departement

Solution By Industry

Solution By Industry

Company

Company